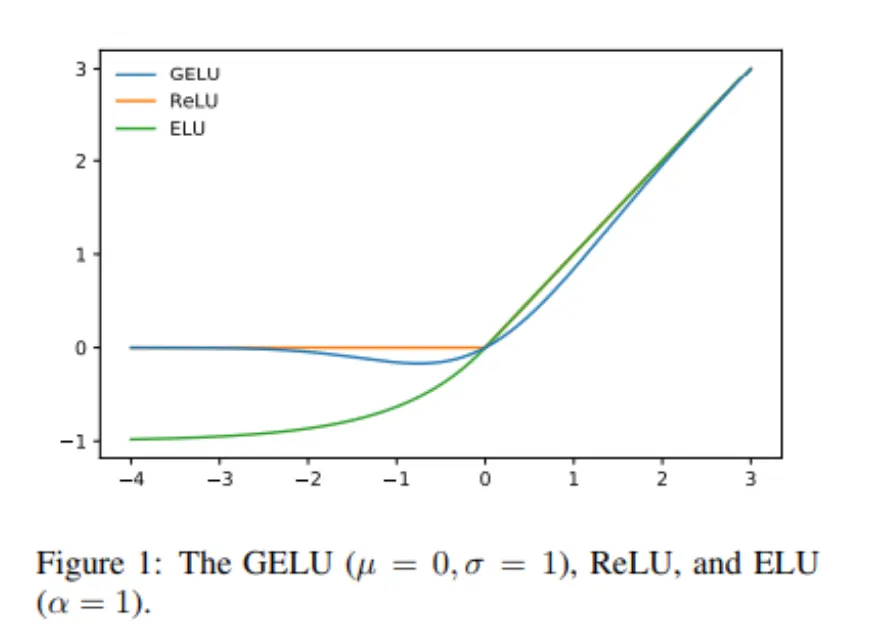

2016년 6월에 발표된 함수이지만 최근 transformer계열 모델들에서 ReLU 대신 거의 대부분 사용되는 함수이다.

•

ReLU의 smoothing version이라고 볼 수 있다. ( 이면 ReLU라고 논문에 명시)

•

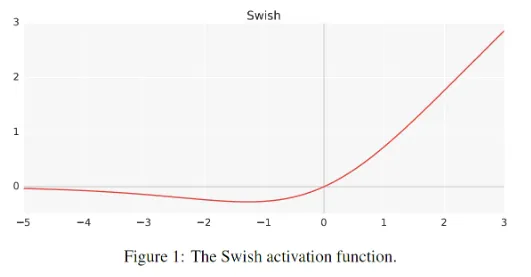

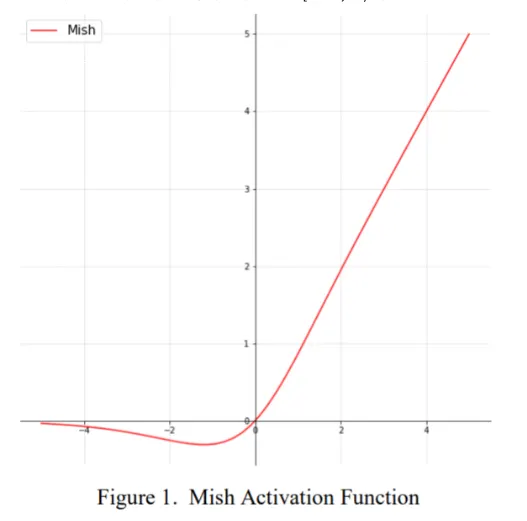

아래의 swish, mish 함수와 유사하게 보인다.

•

bounded below

•

non-monotonic

•

unbounded above

•

smooth

•

모든 점에서 미분 가능

•

x가 다른 입력에 비해 얼마나 큰지에 대한 비율로 gating → 확률적 해석, 미분 가능 형태

•