The Unreasonable Effectiveness of Deep Features as a Perceptual Metric

이 논문에서 제안한 metric이다

PSNR과 SSIM은 너무 단순하고 얕아 인간의 지각에 대한 미묘한 차이를 설명하지 못한다고 주장한다.

L2 Loss 즉 Eucliden distance 와 관련된 PSNR은 픽셀간의 독립성 을 가정하기 때문에 이미지같은 구조화된 결과를 평가하기에는 충분하지 않다

예를 들어 blur 이미지의 경우 perceptual loss는 크나 L2 Loss 는 작은 경향을 갖는다

따라서 인간의 판단과 비슷한 방식으로 두개의 이미지의 유사함을 측정하는 perceptual distance를 원한다

(e.g. SSIM, MSSIM, FSIM, HDP-VDP)

인간의 유사성 판단 기준

1.

고차원 이미지 구조에 의존적이다( high-order image structure )

2.

맥락 의존적 ( context dependent) → 유사성의 감각이 많이 다를 수 있음

예를 들어 빨간원의 그림이 있다. 그러면 이것은 빨간 사각형에 가까운 것인지, 파란 원에 가까운 것인지

문맥에 따라 달라진다

3.

distance metric으로 구성된 것이 아닐 수 있음

high level image classification task로 학습된 깊은 convolution network는 광범위한 representation space에서 매우 유용하다

예를 들어 VGG features는 Neural Style Transfer, Image superresolution, Conditional Image Synthesis에서 매우 유용하다

이 task들에서 VGG feature space에서 perceptual loss라는 distance로 측정해 활용한다.

따라서 저자는 perceptual loss를 더욱 objective한 방법으로 사용하는 법을 제시한다

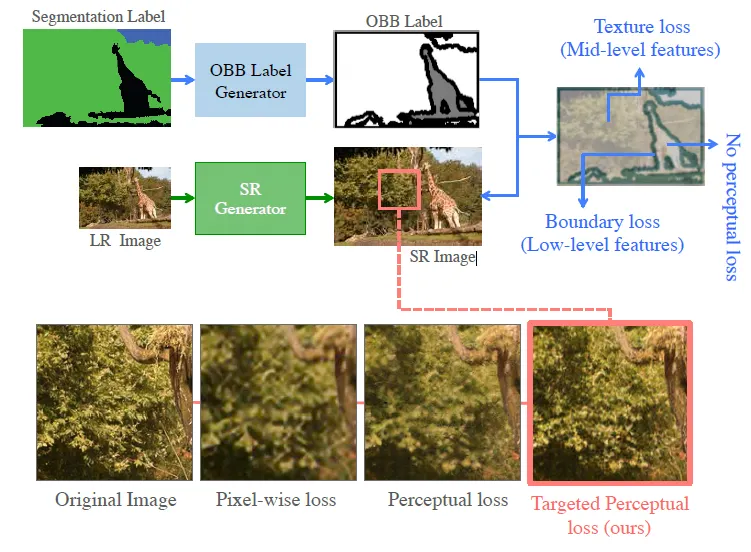

pixel wise segmentation annotation을 OBB label 기법에 활용한다

이를 통해 perceptual feature를 사용해 그림에 나온 것처럼 edge 부근의 loss와 texture 부근의 loss 등을 구하고 ( 이 외의 중요하지 않은 영역에 대해서는 perceptual loss가 계산되지 않는다 ) 그에 적절한 loss를 최소화시키는 방법으로 모델을 학습시킨다