optimizer.zero_grad()

# gradient calculation

loss.backward()

# gradient update

optimizer.step()

Python

복사

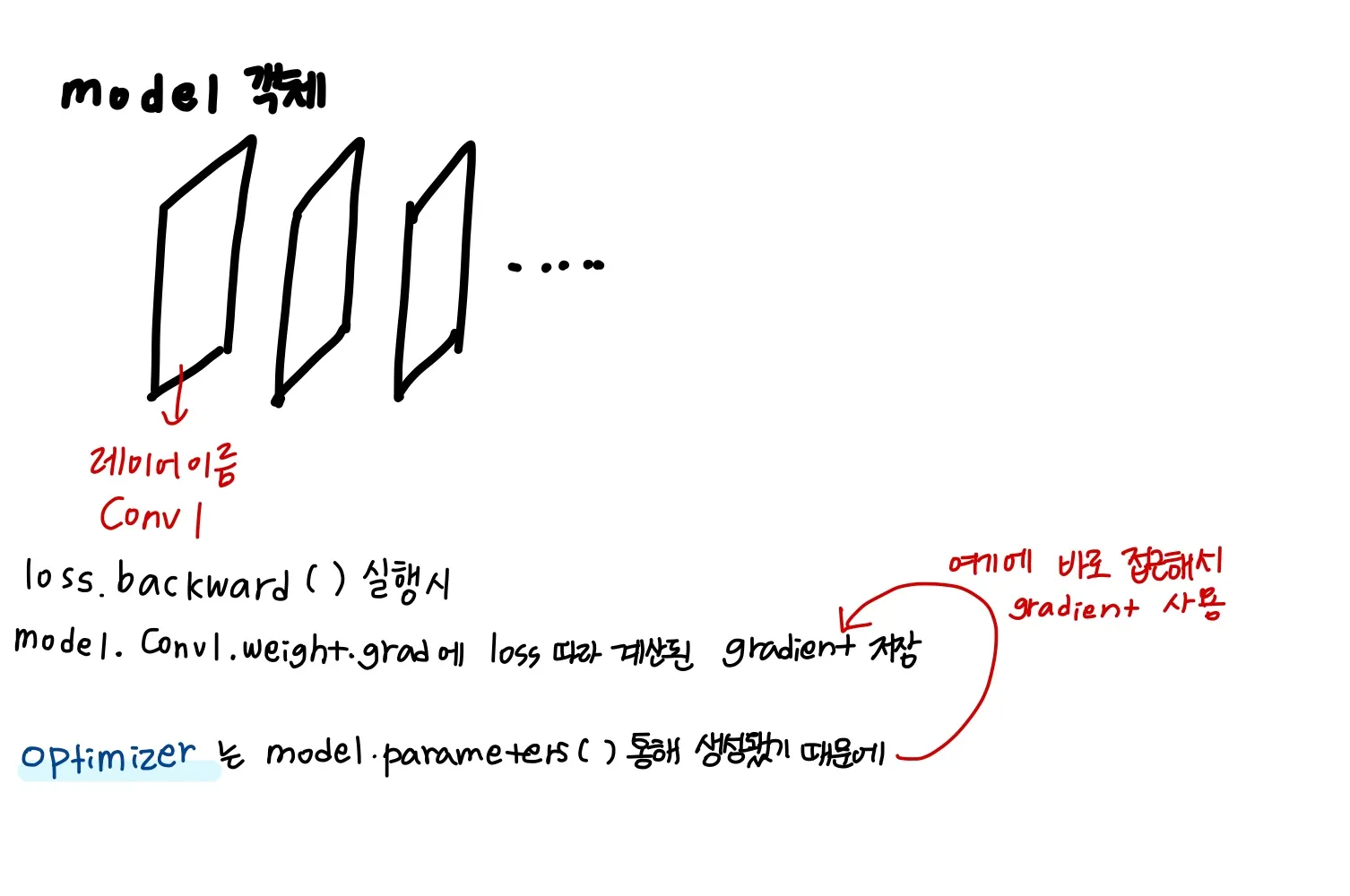

Pytorch에서는

loss 계산

→ gradient 계산(loss.backward()

→ loss에서 계산한 gradient를 기반으로 oprimizer로 weights 업데이트( optimizer.step() )

이 순서로 gradient descent를 통한 웨이트 업데이트가 이뤄지는데

loss와 optimizer 이 둘은 pytorch에서 어떻게 연결되는걸까?