※ 주재걸 교수님의 인공지능을 위한 선형대수 강좌를 기반으로 작성되었습니다

선형결합 (Linear Combinations)

주어진 벡터 in 와 스칼라 에 대해

를 의 coefficients 와의 linear combiation이라 한다.

•

coefficients는 weights라고 할 수도 있으며, 스칼라값이다. zero를 포함한 모든 실수가 가능하다.

•

coefficients가 스칼라값이기에 선형결합의 결과도

matrix equation을 vector equation으로 표현하기

personID | weight (kg) | height (ft) | is_smoking | life-span (year) |

1 | 60 | 5.5 | 1 | 66 |

2 | 65 | 5.0 | 0 | 74 |

3 | 55 | 6.0 | 1 | 78 |

는 matrix equation 이다.

이는 vector equation (벡터방정식)으로 변환될 수 있다

⇒

이는 다음과 같은 선형결합의 형태로 볼 수 있다

이 vector equation을 고려했을 때 의 해는 언제 존재한다고 할 수 있을까?

Span

이 내용에 대해서는 이전 글에서 다뤘다

•

간단히 말해 span은 n차원의 유한한 벡터 p개가 주어졌을 떄 이 벡터들의 선형집합으로 만들어지는 공간

•

의 형태로 나타낼 수 있는 모든 벡터들의 모임

•

따라서 span은 n차원 공간의 부분집합이 된다

이전에 다룬 내용이기에 이정도만 설명한다

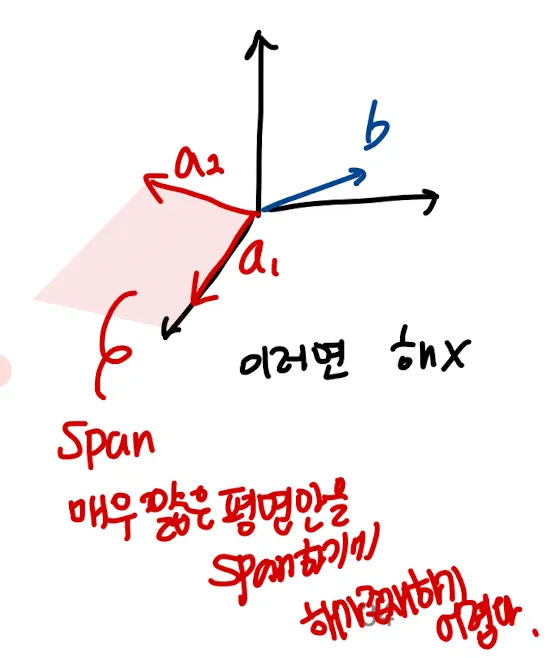

Vector Equation의 Geometric Interpretation

해가 존재한다 = 의 선형결합으로 를 구할 수 있다 = 가 에 속해야 해가 존재한다.

과 만 주어진 상황으로 단순화 했을 때

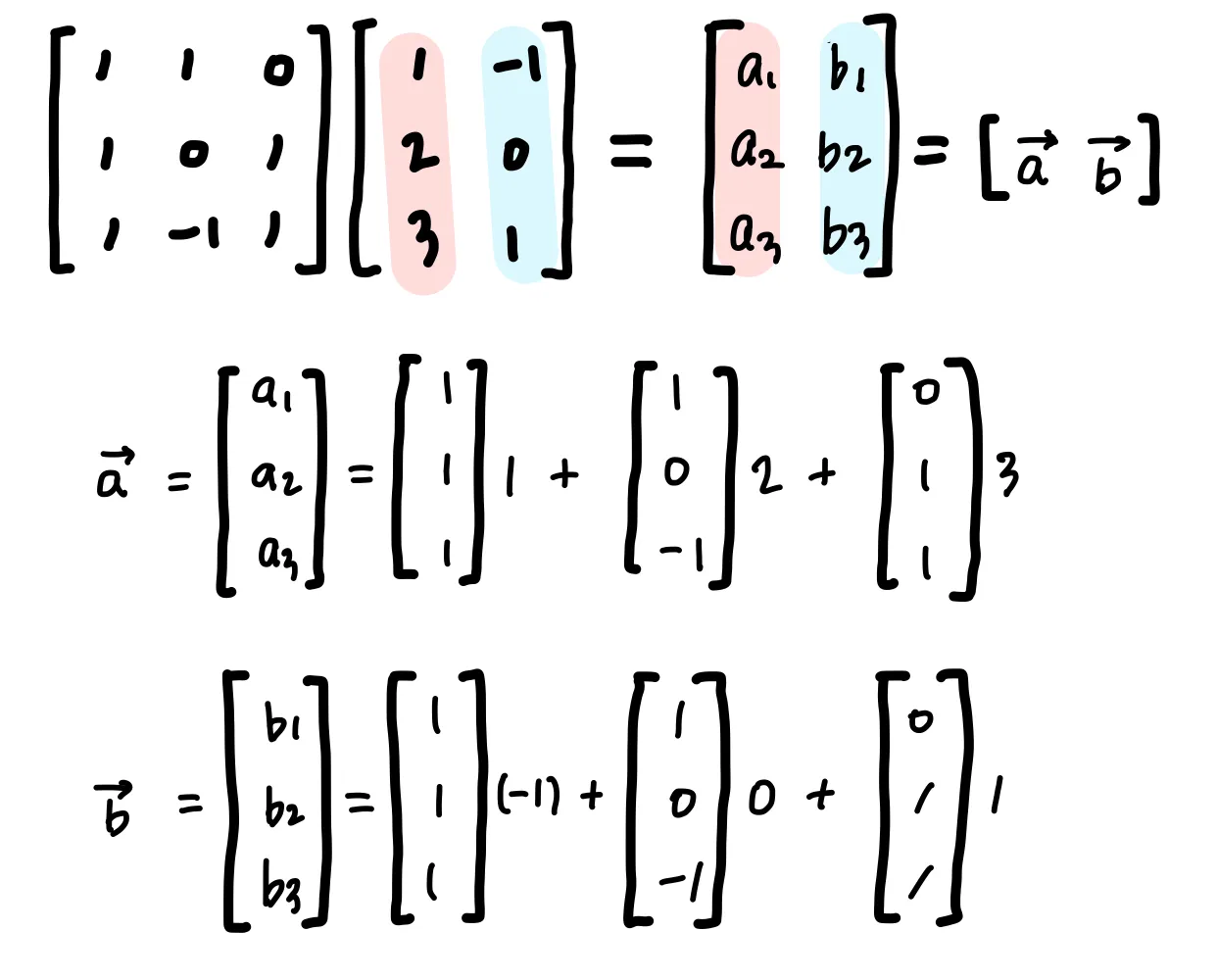

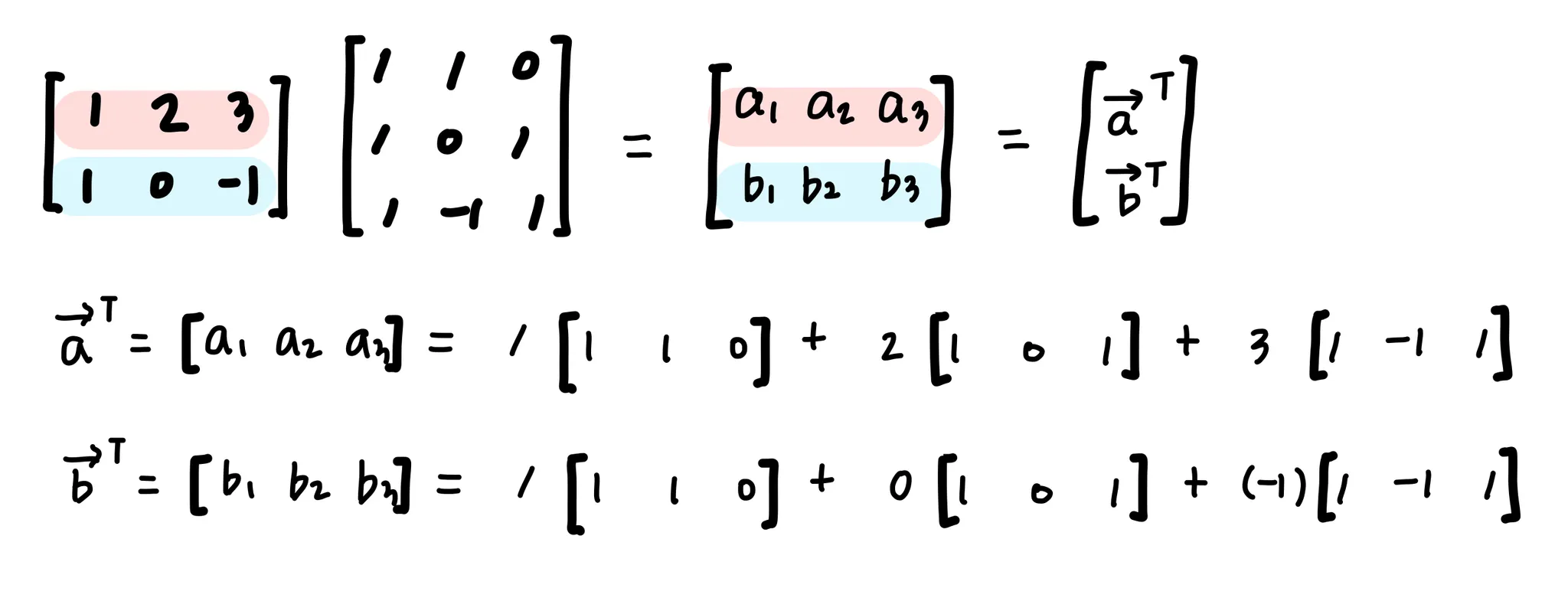

Matrix Equation을 vector의 선형결합으로 살펴보기

행렬과 행렬의 곱을 앞의 행렬의 row와 뒤의 행렬의 column의 inner product로 정의했었다.

1. 왼쪽 행렬의 columns의 선형결합이라 할 수 있다.

2. 오른쪽 행렬의 row의 선형결합이라 할 수 있다.

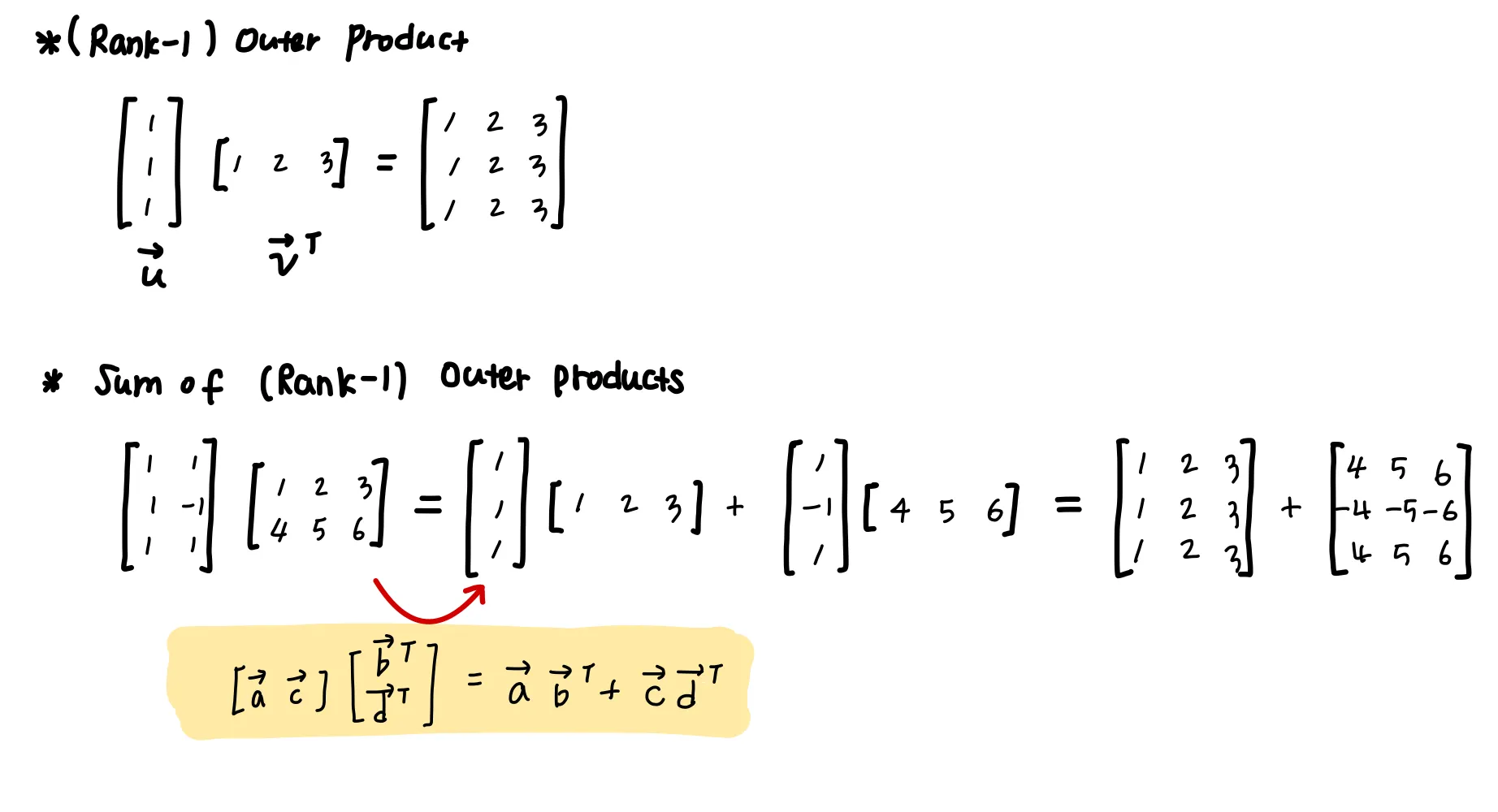

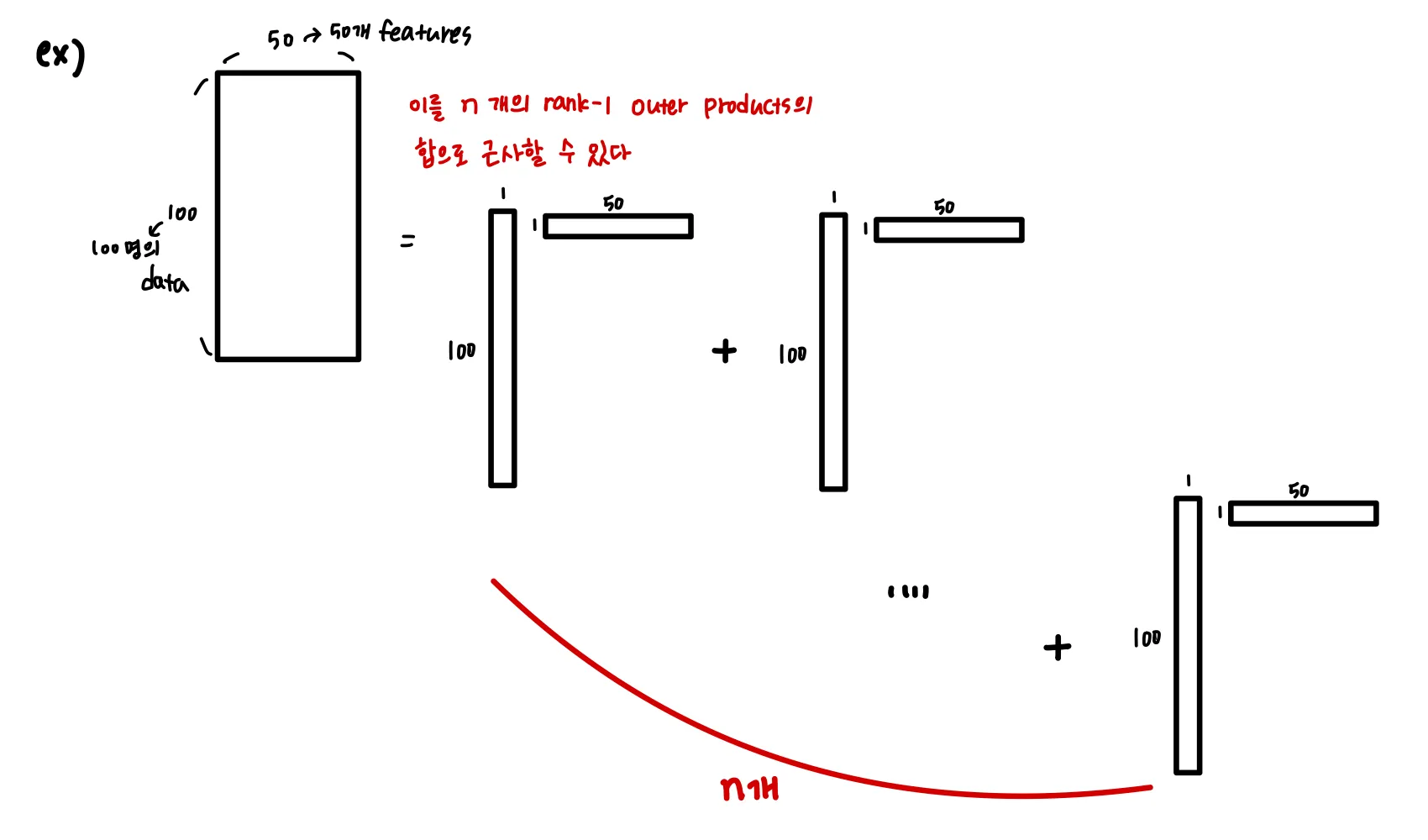

3. Sum of (Rank-1) Outer Products라 할 수 있다.

이 방식이 머신러닝과 가장 가까운 해석이라고 볼 수 있다.

word2vec, PCA, singular value decomposition 등에서 이러한 관점이 사용된다.

•

covariance matrix in multivariate guassian

•

gram matrix in style transfer

⇒ 근사적 표현으로 유용한 역할을 하는 벡터들을 찾을 수 있다.